Mit dem EU AI Act schafft die EU den weltweit ersten umfassenden Rechtsrahmen für Künstliche Intelligenz. Was bisher als technologische Spielwiese galt, wird nun zur regulierten Verantwortung. Künstliche Intelligenz (KI) darf nicht länger unkontrolliert wirken - sie muss sicher, transparent und ethisch sein.

Für Unternehmen, die digitale Sicherheit ernst nehmen, ist das mehr als ein Gesetz. Es ist ein Weckruf. Denn der EU AI Act betrifft nicht nur Entwickler, sondern auch Betreiber und Anwender von KI-Systemen. Die gute Nachricht ist: Wer früh handelt, verschafft sich einen Vorsprung. Denn der EU AI Act zwingt Unternehmen, ihre KI-Strategie zu überdenken, und bietet zugleich die Chance, Vertrauen zu schaffen und sich als verantwortungsvoller Anbieter zu positionieren.

1. Was ist der EU AI Act?

Der EU AI Act ist eine Verordnung der Europäischen Union, mit der ein umfassender Rechtsrahmen für den Einsatz und die Bereitstellung von Künstlicher Intelligenz (KI) in der EU geschaffen werden soll. Das Ziel ist es, Grundrechte und Sicherheit beim Einsatz von KI-Systemen zu schützen, zugleich aber Innovation nicht zu ersticken.

Die Verordnung (EU) 2024/1689 ist seit dem 1. August 2024 in Kraft, allerdings greifen die Regelungen gestaffelt: Erste Verbote gelten bereits seit Februar 2025, viele Pflichten folgen bis August 2026. Daher sollten Unternehmen sich frühzeitig vorbereiten, denn wer KI nutzt, ist betroffen: Ob im Kundenservice, in der Personalabteilung oder in der IT-Sicherheit. Somit betrifft die Verordnung nicht nur Entwickler, sondern auch Anbieter, Betreiber und Nutzer*innen von KI-Systemen (Mit „Nutzer" sind im rechtlichen Sinne Unternehmen oder Organisationen gemeint, die ein KI-System in ihrem Betrieb einsetzen – nicht die Endanwender).

2. Welche KI-Systeme fallen unter den Geltungsbereich und welche nicht?

Der Geltungsbereich des AI Acts ist bewusst breit gefasst. Er betrifft alle Systeme, die laut Verordnung als „Künstliche Intelligenz“ gelten: sprich maschinelle Systeme mit autonomen, adaptiven oder schlussfolgernden Fähigkeiten. Ob regelbasiert, statistisch oder durch maschinelles Lernen: Entscheidend ist, dass das System selbstständig Entscheidungen trifft oder Vorschläge generiert. Ausgenommen sind nur wenige Bereiche, wie etwa KI-Systeme, die ausschließlich für militärische oder nationale Sicherheitszwecke entwickelt wurden. Auch rein private Anwendungen ohne wirtschaftliche Relevanz fallen nicht unter die Verordnung.

Kurz gesagt: Wer KI entwickelt, vertreibt, integriert oder nutzt, sollte prüfen, ob sein System unter den AI Act fällt.

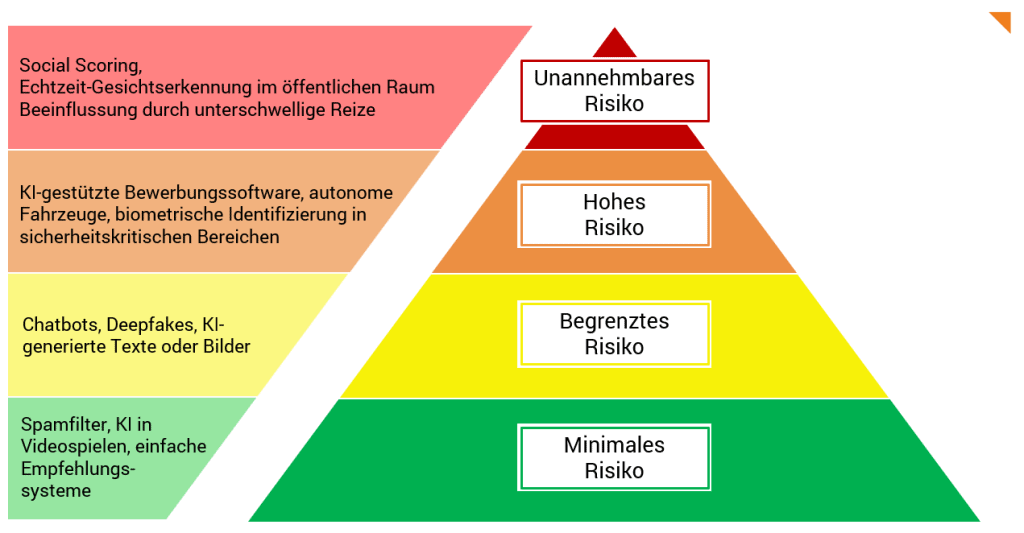

3. Welche Risiko-Kategorien unterscheidet der EU AI Act?

Der EU AI Act verfolgt einen klaren Grundsatz: Je höher das Risiko, desto strenger die Regeln. KI-Systeme werden in vier Risikoklassen mit jeweils unterschiedlichen Pflichten für Anbieter und Nutzer eingeteilt:

Unannehmbares Risiko – verboten

KI-Systeme, die Grundrechte verletzen oder Menschen manipulieren, sind in der EU untersagt.

Hohes Risiko – streng reguliert

Diese Systeme können erheblich in das Leben von Menschen eingreifen. Sie unterliegen umfangreichen Pflichten:

- Risikomanagement und technische Dokumentation

- Transparenz und menschliche Kontrolle

- Registrierung und CE-Kennzeichnung inkl. Konformitätsbewertung

Begrenztes Risiko – Transparenzpflichten

Hier geht es vor allem um die Interaktion mit Menschen. Nutzer*innen müssen erkennen, dass sie mit einer KI kommunizieren. Anbieter müssen sicherstellen, dass Inhalte als KI-generiert gekennzeichnet sind.

Minimales Risiko – keine speziellen Vorgaben

Die meisten alltäglichen KI-Anwendungen fallen in diese Kategorie. Sie sind nicht reguliert, solange sie keine Risiken für Sicherheit oder Grundrechte darstellen.

Diese Risikoklassifizierung ist das Herzstück des AI Acts. Sie entscheidet, ob ein KI-System dokumentiert, überwacht oder sogar verboten werden muss. Unternehmen sollten frühzeitig prüfen, in welche Kategorie ihre Lösungen fallen und welche Pflichten daraus entstehen.

4. Was sind zentrale Pflichten für Anbieter bzw. Nutzer von Hochrisiko-KI-Systemen?

Betreiber von „Hochrisiko“-KI-Systemen müssen mehr als nur technische Qualität bieten. Der EU AI Act verlangt ein umfassendes Sicherheits- und Kontrollsystem mit klaren Zuständigkeiten und dokumentierten Prozessen. Daraus entstehen unterschiedliche Pflichten:

Pflichten für Anbieter

- Risikomanagement: Identifikation, Bewertung und Minimierung potenzieller Risiken vor und während des Betriebs.

- Technische Dokumentation: Vollständige Beschreibung des Systems, seiner Architektur, Algorithmen, Datenquellen und Einsatzbereiche.

- Datenqualität: Nachweise über die Relevanz, Genauigkeit und Fairness der verwendeten Daten.

- Protokollierung: Lückenlose Aufzeichnung von Systemaktivitäten zur Nachvollziehbarkeit.

- Transparenz: Informationen über die Funktionsweise und Grenzen der KI müssen für Nutzer*innen verständlich bereitgestellt werden.

- Menschliche Kontrolle: Mechanismen zur Überwachung und Eingriffsmöglichkeiten durch Menschen sind Pflicht.

- Qualitätsmanagementsystem (QMS): Anbieter müssen ein internes System zur Sicherstellung der Compliance etablieren.

Pflichten für Nutzer*innen (Betreiber)

- Monitoring nach Inbetriebnahme: Kontinuierliche Überwachung der Systemleistung und Risiken.

- Korrekturmaßnahmen: Bei Problemen muss schnell und wirksam reagiert werden.

- Informationspflichten: Nutzer*innen müssen über den Einsatz von KI informiert werden.

Sanktionen bei Verstößen gegen den EU AI Act

Aber Achtung: Der EU AI Act ist kein zahnloser Tiger. Wer gegen zentrale Pflichten verstößt, riskiert empfindliche Strafen:

- Bis zu 35 Millionen Euro oder 7 % des weltweiten Jahresumsatzes bei besonders schweren Verstößen (z. B. Einsatz verbotener KI-Systeme).

- Bis zu 15 Millionen Euro oder 3 % des Umsatzes bei Verstößen gegen Dokumentations-, Transparenz- oder Kontrollpflichten.

- Bis zu 7,5 Millionen Euro oder 1 % des Umsatzes bei falschen oder irreführenden Angaben gegenüber Behörden.

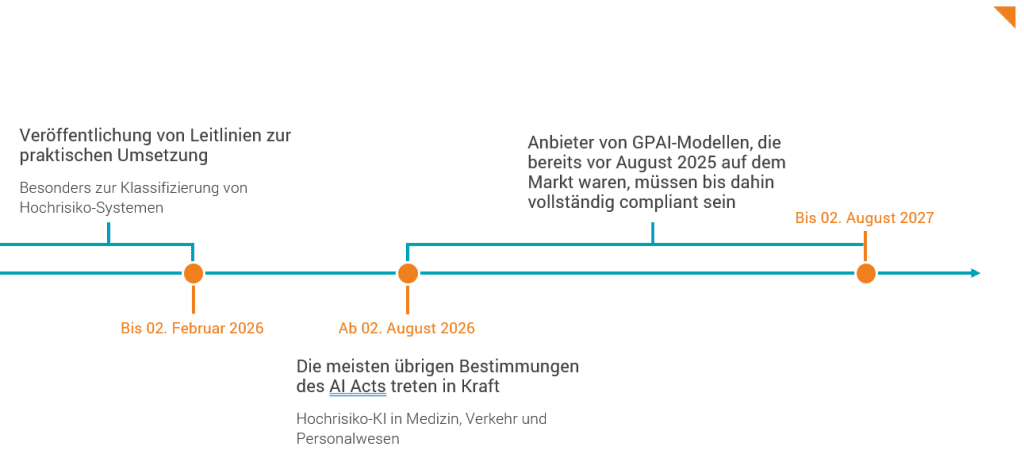

5. Welche Regelungen gelten bereits und wann müssen Unternehmen wie reagieren?

Der EU AI Act ist seit dem 1. August 2024 in Kraft, doch seine Umsetzung erfolgt schrittweise. Unternehmen haben je nach Rolle und Risikoklasse ihrer KI-Systeme unterschiedlich lange Zeit, um sich auf die neuen Anforderungen einzustellen.

Was gilt bereits?

- Seit 2. Februar 2025: Das Verbot besonders riskanter KI-Systeme, z.B. zur Echtzeit-Gesichtserkennung oder zum Social Scoring. Diese dürfen weder entwickelt noch eingesetzt werden.

- Ab 2. August 2025:

- Pflichten für Anbieter von General-Purpose-AI-Modelle (GPAI), z.B. zur Dokumentation, Transparenz und Offenlegung von Trainingsdaten

- Einrichtung von benannten Prüfstellen und Marktüberwachungsbehörden

- Inkrafttreten zentraler Governance- und Sanktionsregelungen

Was kommt noch?

- Bis 2. Februar 2026: Die EU-Kommission muss Leitlinien zur praktischen Umsetzung veröffentlichen, insbesondere zur Klassifizierung von Hochrisiko-Systemen.

- Ab 2. August 2026: Die meisten übrigen Bestimmungen des AI Acts treten in Kraft, wie für Hochrisiko-KI in Medizin, Verkehr oder Personalwesen.

- Bis 2. August 2027: Anbieter von GPAI-Modellen, die bereits vor August 2025 auf dem Markt waren, müssen bis dahin vollständig compliant sein.

6. Was bedeutet das konkret für Unternehmen außerhalb der EU?

Der EU AI Act wirkt über die Grenzen Europas hinaus. Auch Unternehmen mit Sitz außerhalb der EU können betroffen sein, und zwar dann, wenn:

- sie KI-Systeme in den EU-Markt bringen

- ihre KI-Dienste sich gezielt an Nutzer*innen in der EU richten

- oder ihre Systeme innerhalb der EU eingesetzt werden, etwa durch Tochtergesellschaften oder Partner.

Damit entfaltet der AI Act eine extraterritoriale Wirkung, ähnlich wie die DSGVO. Das bedeutet: Nicht der Standort des Unternehmens entscheidet, sondern der Ort der Nutzung oder Vermarktung. Aber was heißt das nun konkret? Auch Anbieter aus den USA, Asien oder anderen Regionen müssen prüfen, ob ihre KI-Produkte oder KI-Dienstleistungen einen Bezug zur EU haben. Falls ja, gelten dieselben Pflichten wie für europäische Unternehmen.

7. Warum ist der EU AI Act wichtig und welche Herausforderungen bestehen?

Warum der EU AI Act zählt:

Der EU AI Act ist ein Meilenstein. Als erste umfassende KI-Regulierung weltweit setzt er Standards nicht nur für Europa, sondern auch für den globalen Umgang mit Künstlicher Intelligenz. Er schafft damit:

- Rechtsklarheit für Unternehmen

- Verbraucherschutz durch verbindliche Regeln

- Vertrauen in KI-Anwendungen bei Kunden, Partnern und Behörden

Gerade für erklärungsbedürftige Technologien ist das entscheidend: Wer KI transparent und verantwortungsvoll einsetzt, gewinnt Glaubwürdigkeit.

Wo die Herausforderungen des EU AI Acts liegen:

Die Umsetzung ist komplex: technisch, organisatorisch und strategisch. Besonders bei Hochrisiko-KI-Systemen sind die Anforderungen hoch:

- Risikomanagement, Dokumentation, Monitoring

- Der Begriff „KI“ bleibt unscharf, sprich: Was fällt wirklich unter die Verordnung?

- Nationale Behörden müssen die Regeln einheitlich auslegen und durchsetzen

- Compliance kann teuer werden, besonders für kleinere Anbieter

Welche Chancen durch den EU AI Act entstehen:

Der AI Act ist nicht nur Pflicht, sondern auch Potenzial. Unternehmen, die frühzeitig handeln, können sich als verantwortungsvolle Anbieter positionieren. Im B2B-Umfeld wird Vertrauen zum echten Wettbewerbsvorteil.

Fazit zum EU AI Act

Der EU AI Act ist kein Stolperstein, sondern ein Kompass. Für alle, die mit KI arbeiten, ist jetzt der richtige Zeitpunkt, die Weichen zu stellen. Wie weit ist Ihr Unternehmen beim Thema KI-Compliance? Wir begleiten Sie dabei, Ihre KI-Strategie aufzustellen.